引言:自动驾驶的”常识困境”

当Waymo的无人车在旧金山街头日均完成1.4万单接送任务时,司机们却评价它”有点楞”——它能精准停车,却读不懂外卖小哥的突然变道;能识别车道线,却猜不透前车双闪背后的紧急状况。自动驾驶技术看似逼近实用门槛,却始终隔着一层”常识”的窗户纸。这背后,是AI从”看见”到”理解”再到”想象”的进化之路,而**世界模型(World Model)**的出现,正让自动驾驶加速突破这一瓶颈。

一、当前自动驾驶的”模块化短板”

主流自动驾驶系统采用”感知-预测-规划”的流水线架构:

- 感知层:摄像头和激光雷达将现实拆解为3D点云和2D标签。

- 预测层:基于历史轨迹推算目标动作。

- 规划层:计算方向盘转角和油门力度。

问题核心:这种割裂设计让机器缺乏”有限观测→完整建模→未来推演”的认知能力。例如:

- 纸箱被风吹起时,系统无法预判落点;

- 小孩追逐皮球时,系统难以想象冲出斑马线的可能性。

人类司机的”常识”(如”积水路面会打滑”)源于对物理规律的内在理解,而这正是当前AI的短板。

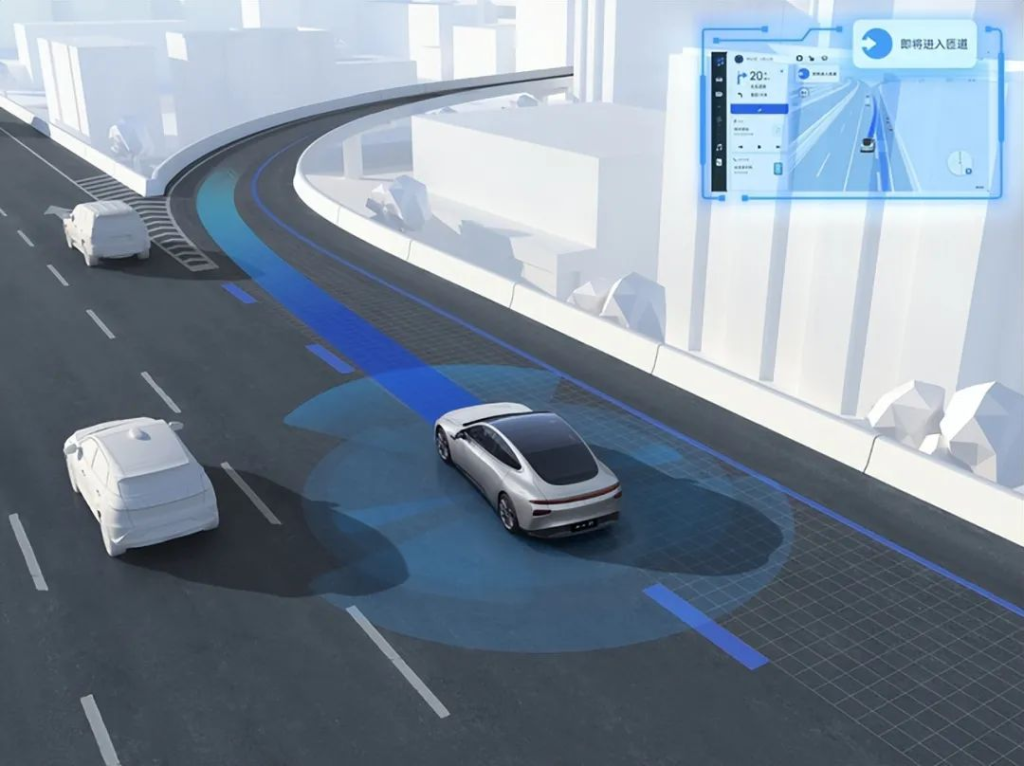

二、世界模型:让机器拥有”数字孪生大脑”

世界模型的突破在于构建了一个可动态推演的”认知闭环”:

- 输入当前路况和假设动作;

- 生成未来3-5秒的视觉流、点云变化甚至摩擦系数波动;

- 基于预演结果优化决策。

案例:蘑菇车联的MogoMind大模型已实现:

- 实时全局感知交通流变化;

- 提前3秒预判路口冲突风险,通行效率提升35%。

三、技术进化史:从”条件反射”到”物理推理”

- 纯视觉模型(2016年):

- 如NVIDIA Dave-2,通过CNN将像素直接映射为方向盘角度。

- 缺陷:”数据依赖症”,无法应对训练外的场景(如侧翻卡车)。

- 多模态融合(2019年后):

- BEV技术统一摄像头、雷达数据,解决视角盲区问题。

- 局限:仍是”感知增强”,无法理解”行人拎塑料袋可能遮挡视线”。

- 视觉-语言模型(2021年后):

- GPT-4V等能”看图说话”(如解释”前车急刹因猫窜出”)。

- 问题:依赖文本相关性,丢失物理细节(如湿井盖摩擦系数)。

- 视觉-语言-动作模型(2024年):

- NVIDIA VIMA等可直接将语言指令转化为机械臂动作。

- 短板:缺乏物理微分理解,无法推导”结冰路面需3倍刹车距离”。

- 世界模型(当下):

- 核心架构V-M-C(视觉-记忆-控制器):

- Vision:用VQ-VAE提取关键特征;

- Memory:通过GRU和MDN预测未来帧;

- Controller:生成最优动作。

- “梦境训练”机制:在云端以1000倍实时速度预演极端场景,零成本积累经验。

- 核心架构V-M-C(视觉-记忆-控制器):

四、物理AI:让”想象”符合现实规律

世界模型需解决的核心问题是物理一致性:

- 神经PDE混合架构:

- 用傅里叶神经算子(FNO)模拟流体力学,预测”积水刹车距离”误差从30%降至5%。

- 物理一致性损失函数:

- 对”违反惯性定律”的幻想(如SUV瞬间平移5米)施加惩罚。

- 多粒度Token物理引擎:

- 将世界拆分为刚体、流体等token,模拟”床垫掉落飘移路径”精度提升40%。

案例:MogoMind在暴雨中提前500米预警积水风险,实现”反事实推理”(模拟”不减速会碰撞”的可能性)。

五、落地路线图:从”离线增强”到”端到端控制”

- 2024-2025年:离线数据增广

- 生成极端场景视频(如货车遗撒障碍物),误报率下降27%。

- 2025年:闭环影子模式

- 车端Memory模型以5次/秒频率预演未来2秒路况,偏差数据回传云端。

- 2026-2027年:端到端物理VLA

- 车端算力突破500TOPS后,V-M-C全链路直接接管决策,实现”老司机级”预判。

六、挑战与未来:数据、算力与伦理

- 数据瓶颈:需带摩擦系数等标注的视频,开源社区(如清华MARS数据集)提供解决方案。

- 算力成本:混合精度训练将成本降低4倍,8位量化让车端功耗仅25瓦。

- 安全伦理:

- “保守策略+人机共驾”:碰撞概率超3%时降级辅助驾驶;

- 数字孪生沙盒预演极端场景,确保道德底线。

结语:一场认知革命

世界模型不仅让自动驾驶突破”老司机”瓶颈,更重新定义了”智能”——从CNN的”识别”到Transformer的”关联”,再到世界模型的”想象”。当机器能在脑海中预演未来,其影响将远超汽车领域,重塑机器人、元宇宙甚至智慧城市。或许不久后,我们会感叹:“它不只是更聪明,而是终于像人一样理解世界了。”